'Hadoop' 카테고리의 다른 글

| windows 에서 hadoop 시작 하기. (0) | 2014.08.14 |

|---|---|

| windows 에서 hadoop 설치 (3) | 2014.08.13 |

| windows 에서 hadoop 시작 하기. (0) | 2014.08.14 |

|---|---|

| windows 에서 hadoop 설치 (3) | 2014.08.13 |

Directory of D:\hadoop-2.4.1 01/18/2014 08:11 AM <DIR> . 01/18/2014 08:11 AM <DIR> .. 01/18/2014 08:28 AM <DIR> bin 01/18/2014 08:28 AM <DIR> etc 01/18/2014 08:28 AM <DIR> include 01/18/2014 08:28 AM <DIR> libexec 01/18/2014 08:28 AM <DIR> sbin 01/18/2014 08:28 AM <DIR> share 0 File(s) 0 bytes

D:\hadoop-2.4.1\etc\hadoop\hadoop-env.cmd 파일을 열고 마지막 줄 밑에 추가한다.

set HADOOP_PREFIX=D:\hadoop-2.4.1

set HADOOP_CONF_DIR=%HADOOP_PREFIX%\etc\hadoop

set YARN_CONF_DIR=%HADOOP_CONF_DIR%

set PATH=%PATH%;%HADOOP_PREFIX%\bin같은 경로의 core-site.xml 파일도 아래와 같이 수정

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://0.0.0.0:19000</value>

</property>

</configuration>같은 경로의 hdfs-site.xml 파일도 아래와 같이 수정

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>slaves 파일도 아래와 같은지 확인

localhost

<configuration>

<property>

<name>mapreduce.job.user.name</name>

<value>%USERNAME%</value>

</property>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>yarn.apps.stagingDir</name>

<value>/user/%USERNAME%/staging</value>

</property>

<property>

<name>mapreduce.jobtracker.address</name>

<value>local</value>

</property>

마지막으로 yarn-site.xml 파일 수정

<configuration>

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce_shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> <property> <name>yarn.resourcemanager.address</name> <value>127.0.0.1:8032</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>127.0.0.1:8030</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>127.0.0.1:8031</value> </property> </configuration>

Windows SDK 7.1 Command Prompt 실행

에러가 없는지 확인.

완료가 되면 ex) D:\tmp 디렉토리에 파일시스템이 생깁니다.

아래와 같이 나오면 된듯?

그밖에 많은 하둡 명령어 들이 있다.

http://hadoop.apache.org/docs/r0.18.3/hdfs_shell.html 참조

다음은 맵리듀스 예제.

먼저 yarn을 실행

hadoop을 찾을 수 없다면 etc/hadoop/hadoop-env 를 실행하고 해보자

yarn을 실행 시키고 http://localhost:8088/ 에 접속라면 리소스매니저라는 웹 페이지가 있다.

sbin/hadoop-all 을 열어보면 hdfs , yarn이 실행 되는것을 볼때.

하둡은 이 두가지 서비스 라는것으로 볼 수 있다.

HDFS : Hadoop Distributed File System

http://hadoop.apache.org/docs/r1.2.1/hdfs_design.html

YARN : Apache Hadoop NextGen MapReduce (YARN)

http://hadoop.apache.org/docs/current/hadoop-yarn/hadoop-yarn-site/YARN.html

| flume 정리. (0) | 2014.10.08 |

|---|---|

| windows 에서 hadoop 설치 (3) | 2014.08.13 |

뭔지 모르겠지만 일단 설치시작해보자!

windows에서 hadoop 설치는 고난의 연속이라고 들은 적이 있으나 스터디가 목적이므로 강행 하였다.

일단 : http://hadoop.apache.org/ 에 접속하여 살펴보기.

사용법이 리눅스 기준이네...

windows 에서 빌드하려면 http://wiki.apache.org/hadoop/Hadoop2OnWindows 를 참조하라고 한다.

그럼 설치 시작!

1. 지원하는?(테스트 해본, 될것같은) windows버전 이다.

이제부터 난이도 상승...

http://wiki.apache.org/hadoop/Hadoop2OnWindows 페이지에

1. Hadoop 빌드 전에 필요한 것들 설치하기

1. JAVA 설치 : http://oracle.com

2. MAVEN 설치 : https://cygwin.com/install.html

3. Cygwin. 설치:http://maven.apache.org/download.cgi

4. Microsoft Windows SDK v7.1. 설치 : http://www.microsoft.com/en-in/download/details.aspx?id=8279

5. Protocol Buffers 2.5.0 다운받아 압축풀기 : http://protobuf.googlecode.com/files/protoc-2.5.0-win32.zip

- ex) D:\install\protoc-2.5.0-win32

6. zlib 압축 풀기 : http://www.zlib.net/

- ex) D:\install\zlib128-dll

어짜피 에러나면 설치해야 하니 미리 설치하는것이 좋다.

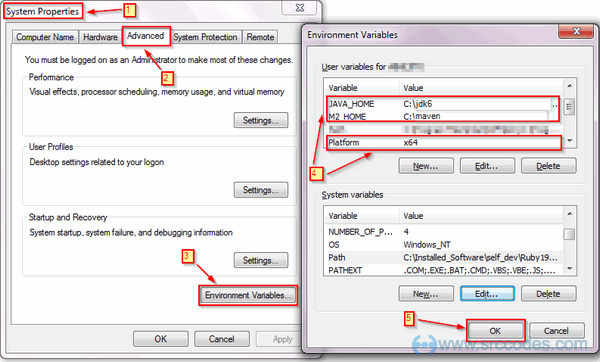

JAVA_HOME 설정, M2_HOME(안해도 됨), Platform 환경 변수 세팅.

set Platform=x64 (when building on a 64-bit system)

set Platform=Win32 (when building on a 32-bit system)

이 값은 (case-sensitive) 대소문자를 구별하므로 주의 합시다!

"Platform" O

"PLATFORM" X

"platform" X

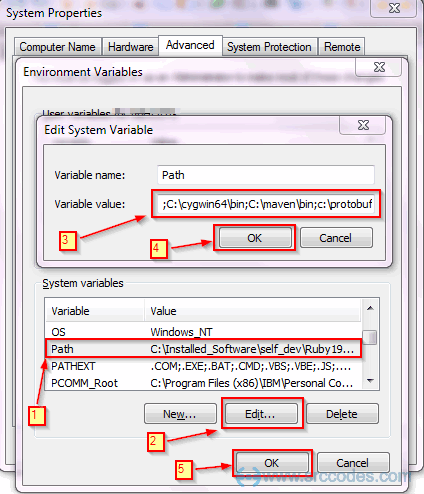

CygWin, maven, ProtocolBuffer 디렉토리를 path 에 등록 exe가 있는 디렉토리를 등록해야 한다.

다운로드 받은 hadoop-2.4.1-src.tar.gz 의 압축을 풀고 위치를 정해 카피헤 놓는다.

ex) D:\install\hadoop-2.4.1-src

2. maven 빌드 하기.

command안된다, Cywin 안된다. Windows SDK 7.1 Command Prompt 를 사용해야 한다.

windows SDK7.1 을 설치 했다면 아래 경로에 실행파일이 있을 것이다.

Select Start --> All Programs --> Microsoft Windows SDK v7.1 and open Windows SDK 7.1 Command Prompt

D:\install\hadoop-2.4.1-src 경로로 이동 후 아래 명령어 입력

빌드중.......

아마 에러가 날것 이다.

에러 로그 조금 위를 보면 cannot open include file zlib.h windows 이런 내용?이 있다 컴파일 에러...

c 컴파일 하다가 에러나네.. 아.. 뭐지..

D:\install\zlib128-dll 디렉 토리를 보면 include 디렉토리에 있는 zlib.h,zconf.h 를 복사하여

D:\install\zlib128-dll 디렉토리에 복사 하고 다시 실행 하니 잘된다.

다시빌드.. 이건또 뭔 에러여..

D:\install\hadoop-2.4.1-src 우클릭 > 속성 > 보안 > 사용자별 권한 모두

그런데 안된다...

우린 이미 Cywin을 path에 넣었다

D:\install 디렉토리로 이동 chmod -R 777 hadoop-2.4.1-src

다시 빌드 ... 우왕 성공!

시행 착오들

-> ProtocolBuffer 를 다운받고 path에 등록 하자.

http://www.srccodes.com/p/article/38/build-install-configure-run-apache-hadoop-2.2.0-microsoft-windows-os -> 이형네 스크린샷을 퍼왔습니다.

| flume 정리. (0) | 2014.10.08 |

|---|---|

| windows 에서 hadoop 시작 하기. (0) | 2014.08.14 |